水平扩展让我们能够:

- 轻松应对海量数据涌入

- 将处理负载分布到多个节点

- 提高容错能力(谁不喜欢一个好的故障转移呢?)

- 即使数据量激增也能保持低延迟

但问题在于:水平扩展 Kafka Streams 并不像增加更多实例那么简单。哦,不,我的朋友们。这更像是打开了分布式系统挑战的潘多拉盒子。

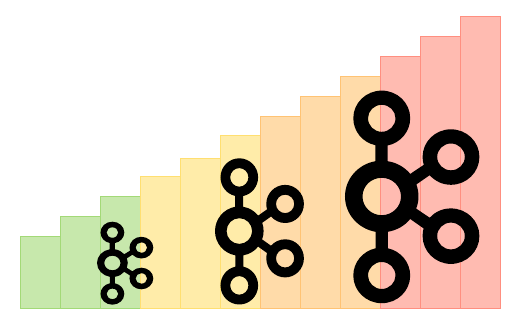

Kafka Streams 扩展的结构

在我们深入探讨问题之前,先快速了解一下 Kafka Streams 是如何扩展的。虽然这不是魔法(遗憾的是),但确实很聪明:

- Kafka Streams 将你的拓扑划分为任务

- 每个任务处理一个或多个输入主题的分区

- 当你添加更多实例时,Kafka Streams 会重新分配这些任务

听起来很简单,对吧?好吧,抓紧你的咖啡杯,因为事情开始变得有趣了(而我所说的有趣,意味着可能会让人抓狂)。

有状态操作的挑战

在扩展 Kafka Streams 时,最大的挑战之一来自处理有状态操作。你知道的,那些既让我们的生活更简单又更复杂的聚合和连接操作。

问题在于?状态。它无处不在,而且不喜欢移动。

“状态就像那个总是在聚会结束后还不走的朋友。虽然有它在很有用,但离开(或者在我们的情况下,扩展)时真的很麻烦。”

当你扩展时,Kafka Streams 需要移动状态。这会导致一些棘手的情况:

- 状态迁移期间的临时性能下降

- 如果处理不当,可能导致数据不一致

- 随着状态的移动,网络流量增加

为了减轻这些问题,你需要密切关注你的 RocksDB 配置。以下是一个示例代码片段:

Properties props = new Properties();

props.put(StreamsConfig.ROCKSDB_CONFIG_SETTER_CLASS_CONFIG, CustomRocksDBConfig.class);

在你的 CustomRocksDBConfig 类中:

public class CustomRocksDBConfig implements RocksDBConfigSetter {

@Override

public void setConfig(final String storeName, final Options options, final Map configs) {

BlockBasedTableConfig tableConfig = new BlockBasedTableConfig();

tableConfig.setBlockCacheSize(50 * 1024 * 1024L);

tableConfig.setBlockSize(4096L);

options.setTableFormatConfig(tableConfig);

options.setMaxWriteBufferNumber(3);

}

}

这种配置可以通过优化 RocksDB 的数据处理来减少状态迁移的影响。但请记住,这里没有一刀切的解决方案。你需要根据具体的使用场景进行调整。

再平衡的艺术

向你的 Kafka Streams 应用程序添加新实例会触发再平衡。理论上,这很好——这是我们分配负载的方式。实际上,这就像在为派对穿衣的同时重新整理你的衣柜。

在再平衡期间:

- 处理暂停(希望你不需要立即获取这些数据!)

- 状态需要迁移(参见我们之前关于有状态操作的讨论)

- 你的系统可能会经历暂时的高延迟

为了尽量减少再平衡的痛苦,请考虑以下几点:

- 使用粘性分区以减少不必要的分区移动

- 实现自定义分区分配器以获得更多控制

- 调整你的

max.poll.interval.ms以允许在再平衡期间有更长的处理时间

以下是在你的 Quarkus 应用程序中配置粘性分区的方法:

quarkus.kafka-streams.partition.assignment.strategy=org.apache.kafka.streams.processor.internals.StreamsPartitionAssignor

性能悖论

有趣的事实:有时增加更多实例实际上会降低你的整体性能。我知道,这听起来像个糟糕的笑话,但这确实是事实。

罪魁祸首?

- 增加的网络流量

- 更频繁的再平衡

- 更高的协调开销

为了解决这个问题,你需要在扩展时采取战略性措施。以下是一些建议:

- 密切监控你的吞吐量和延迟

- 以较小的增量进行扩展

- 优化你的主题分区策略

说到监控,以下是如何在你的 Quarkus 应用程序中设置一些基本指标的快速示例:

@Produces

@ApplicationScoped

public KafkaStreams kafkaStreams(KafkaStreamsBuilder builder) {

Properties props = new Properties();

props.put(StreamsConfig.METRICS_RECORDING_LEVEL_CONFIG, Sensor.RecordingLevel.DEBUG.name());

return builder.withProperties(props).build();

}

这将为你提供更详细的指标,帮助你在扩展时识别性能瓶颈。

数据一致性难题

随着我们扩展,保持数据一致性变得更加棘手。请记住,Kafka Streams 保证在分区内的处理顺序,但当你在多个实例和再平衡之间进行切换时,事情可能会变得混乱。

关键挑战包括:

- 确保跨实例的精确一次语义

- 在再平衡期间处理乱序事件

- 管理分布式状态存储中的时间窗口

为了解决这些问题:

- 使用精确一次处理保证(但要注意性能权衡)

- 实现适当的错误处理和重试机制

- 考虑使用自定义

TimestampExtractor以更好地控制事件时间

以下是在你的 Quarkus 应用程序中配置精确一次语义的方法:

quarkus.kafka-streams.processing.guarantee=exactly_once

但请记住,能力越大,责任越大(以及可能增加的延迟)。

错误处理的头痛

当你处理分布式系统时,错误不仅是可能的——它们是不可避免的。在扩展的 Kafka Streams 应用程序中,错误处理变得更加关键。

常见的错误场景包括:

- 网络分区导致实例不同步

- 由于模式更改导致的反序列化错误

- 可能会破坏整个流的处理异常

为了构建更具弹性的系统:

- 在你的流处理器中实现强大的错误处理

- 为处理失败的消息使用死信队列(DLQ)

- 设置适当的监控和警报以快速检测问题

以下是如何在你的 Kafka Streams 拓扑中实现 DLQ 的简单示例:

builder.stream("input-topic")

.mapValues((key, value) -> {

try {

return processValue(value);

} catch (Exception e) {

// 发送到 DLQ

producer.send(new ProducerRecord<>("dlq-topic", key, value));

return null;

}

})

.filter((key, value) -> value != null)

.to("output-topic");

这样,任何处理失败的消息都会被发送到 DLQ 以供后续检查和可能的重新处理。

Quarkus 的独特之处

现在,你可能在想,“好吧,但 Quarkus 在这一切中扮演了什么角色?”好吧,我的朋友,Quarkus 为 Kafka Streams 扩展派对带来了自己的风味。

一些 Quarkus 特定的考虑因素:

- 利用 Quarkus 的快速启动时间以实现更快的扩展

- 使用 Quarkus 的配置选项来微调 Kafka Streams

- 利用 Quarkus 的本地编译以提高性能

这里有一个巧妙的技巧:你可以使用 Quarkus 的配置属性根据环境动态调整你的 Kafka Streams 配置。例如:

%dev.quarkus.kafka-streams.bootstrap-servers=localhost:9092

%prod.quarkus.kafka-streams.bootstrap-servers=${KAFKA_BOOTSTRAP_SERVERS}

quarkus.kafka-streams.application-id=${KAFKA_APPLICATION_ID:my-streams-app}

这使你可以轻松地在开发和生产配置之间切换,使你的扩展生活更轻松。

总结:扩展的故事继续

在 Quarkus 中水平扩展 Kafka Streams 并不是一件轻松的事情。这更像是穿越充满有状态流沙、再平衡藤蔓和性能吞噬者的密集丛林。但凭借正确的知识和工具,你可以驾驭这片领域,构建真正可扩展、弹性的流处理应用程序。

记住:

- 监控,监控,再监控——你无法修复你看不到的问题

- 在进入生产环境之前彻底测试你的扩展策略

- 准备好迭代和微调你的配置

- 接受挑战——它们让我们成为更好的工程师(或者我一直这样告诉自己)

当你开始你的 Kafka Streams 扩展之旅时,请随时参考本指南。记住,当你不确定时,增加更多实例!(开玩笑,请不要在没有适当计划的情况下这样做。)

祝你流处理愉快,愿你的分区始终完美平衡!