流可以让你逐块读取或写入数据,而不需要将整个数据集加载到内存中。当你处理大数据或实时信息时,这非常重要。

但为什么你应该关心呢?想象一下,你正在构建下一个Netflix。你希望用户能够立即开始观看视频,而不是等待整个文件下载。这就是流的用武之地。它们允许你以较小的块处理数据,使你的应用程序更高效和响应迅速。

流的类型:选择你的战士

Node.js 提供了四种类型的流,每种都有其独特的功能:

- 可读流:用于读取数据。可以把它想象成你应用程序的眼睛。

- 可写流:用于写入数据。这是你应用程序的笔。

- 双工流:既可以读取也可以写入。就像同时拥有眼睛和笔。

- 转换流:一种特殊的双工流,可以在传输数据时修改数据。可以把它想象成你应用程序的大脑,实时处理信息。

流的工作原理:数据流的基础

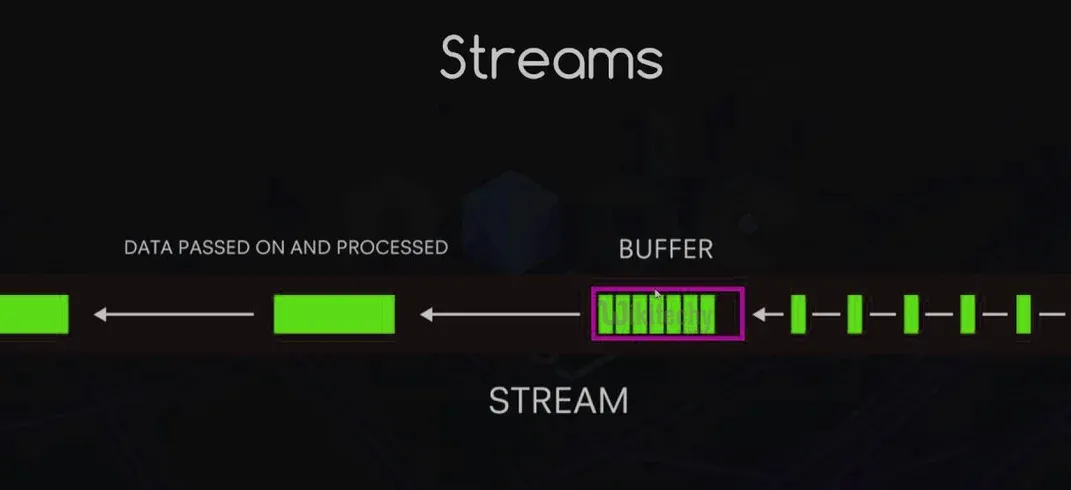

想象一下工厂里的传送带。数据块沿着这条带子移动,一次处理一个。这基本上就是流的工作方式。它们在数据流经时发出事件,让你可以连接到过程的不同部分。

以下是主要事件的快速概述:

data:当有数据可读时发出。end:表示所有数据已被读取。error:休斯顿,我们有问题!finish:所有数据已被刷新到底层系统。

使用流的优势:为什么你应该加入潮流

使用流不仅仅是为了看起来很酷(虽然这确实让你看起来很棒)。以下是使用它们的一些实在理由:

- 内存效率:处理大量数据而不耗尽所有内存。

- 时间效率:立即开始处理数据,不必等待全部加载。

- 可组合性:轻松将流连接在一起,创建强大的数据管道。

- 内置背压:自动管理数据流速度,以防止目的地超载。

实现可读和可写流:代码时间!

让我们动手写一些代码。首先,创建一个简单的可读流:

const { Readable } = require('stream');

class CounterStream extends Readable {

constructor(max) {

super();

this.max = max;

this.index = 1;

}

_read() {

const i = this.index++;

if (i > this.max) {

this.push(null);

} else {

const str = String(i);

const buf = Buffer.from(str, 'ascii');

this.push(buf);

}

}

}

const counter = new CounterStream(5);

counter.on('data', (chunk) => console.log(chunk.toString()));

counter.on('end', () => console.log('Finished counting!'));

这个可读流将从1计数到5。现在,让我们创建一个可写流,它将我们的数字加倍:

const { Writable } = require('stream');

class DoubleStream extends Writable {

_write(chunk, encoding, callback) {

console.log(Number(chunk.toString()) * 2);

callback();

}

}

const doubler = new DoubleStream();

counter.pipe(doubler);

运行这个,你会看到数字2, 4, 6, 8, 10被打印出来。神奇吧!

使用双工和转换流:双向通道

双工流就像进行电话交谈——数据可以双向流动。这里是一个简单的例子:

const { Duplex } = require('stream');

class DuplexStream extends Duplex {

constructor(options) {

super(options);

this.data = ['a', 'b', 'c', 'd'];

}

_read(size) {

if (this.data.length) {

this.push(this.data.shift());

} else {

this.push(null);

}

}

_write(chunk, encoding, callback) {

console.log(chunk.toString().toUpperCase());

callback();

}

}

const duplex = new DuplexStream();

duplex.on('data', (chunk) => console.log('Read:', chunk.toString()));

duplex.write('1');

duplex.write('2');

duplex.write('3');

转换流就像内置处理器的双工流。这里有一个将小写字母转换为大写字母的例子:

const { Transform } = require('stream');

class UppercaseTransform extends Transform {

_transform(chunk, encoding, callback) {

this.push(chunk.toString().toUpperCase());

callback();

}

}

const upperCaser = new UppercaseTransform();

process.stdin.pipe(upperCaser).pipe(process.stdout);

试着运行这个并输入一些小写文本。看着它神奇地变成大写!

处理流事件:捕捉所有动作

流会发出各种事件,你可以监听和处理。以下是快速概述:

const fs = require('fs');

const readStream = fs.createReadStream('hugefile.txt');

readStream.on('data', (chunk) => {

console.log(`Received ${chunk.length} bytes of data.`);

});

readStream.on('end', () => {

console.log('Finished reading the file.');

});

readStream.on('error', (err) => {

console.error('Oh no, something went wrong!', err);

});

readStream.on('close', () => {

console.log('Stream has been closed.');

});

流管道:构建你的数据高速公路

管道使得将流连接在一起变得容易。这就像为数据构建一个鲁布·戈德堡机器!这里是一个例子:

const { pipeline } = require('stream');

const fs = require('fs');

const zlib = require('zlib');

pipeline(

fs.createReadStream('input.txt'),

zlib.createGzip(),

fs.createWriteStream('input.txt.gz'),

(err) => {

if (err) {

console.error('Pipeline failed', err);

} else {

console.log('Pipeline succeeded');

}

}

);

这个管道读取一个文件,压缩它,并将压缩的数据写入一个新文件。所有这些都在一个流畅的操作中完成!

缓冲与流:对决

想象一下你在一个自助餐厅。缓冲就像在吃之前把整个盘子装满,而流则是一次吃一口。以下是何时使用每种方法:

- 使用缓冲当:

- 数据集很小

- 你需要随机访问数据

- 你正在执行需要整个数据集的操作

- 使用流当:

- 处理大型数据集

- 处理实时数据

- 构建可扩展和内存高效的应用程序

管理背压:不要让你的管道爆裂!

背压是当数据进入速度快于处理速度时发生的情况。这就像试图将一加仑水倒入一品脱玻璃杯——事情会变得混乱。Node.js 流具有内置的背压处理,但你也可以手动管理:

const writable = getWritableStreamSomehow();

const readable = getReadableStreamSomehow();

readable.on('data', (chunk) => {

if (!writable.write(chunk)) {

readable.pause();

}

});

writable.on('drain', () => {

readable.resume();

});

这段代码在可写流的缓冲区已满时暂停可读流,并在缓冲区排空时恢复它。

实际应用:流在行动

流不仅仅是一个酷炫的派对技巧。它们在实际应用中经常被使用。以下是一些例子:

- 文件处理:读取和写入大型日志文件

- 媒体流:提供视频和音频内容

- 数据导入/导出:处理大型CSV文件

- 实时数据处理:分析社交媒体信息流

性能优化:为你的流加速

想让你的流更快吗?以下是一些技巧:

- 对于二进制数据,使用

Buffer而不是字符串 - 增加

highWaterMark以提高吞吐量(但要注意内存使用) - 使用

Cork()和uncork()来批量写入 - 实现自定义

_writev()以更高效地批量写入

调试和错误处理:当流出错时

流可能很难调试。以下是一些策略:

- 使用

debug模块记录流事件 - 始终处理

'error'事件 - 使用

stream.finished()检测流何时完成或遇到错误

const { finished } = require('stream');

const fs = require('fs');

const rs = fs.createReadStream('file.txt');

finished(rs, (err) => {

if (err) {

console.error('Stream failed', err);

} else {

console.log('Stream is done reading');

}

});

rs.resume(); // 排空流

工具和库:为你的流增效

有很多库可以让使用流变得更容易。以下是一些值得一试的:

- through2:简化流构建

- concat-stream:将字符串或二进制数据连接起来的可写流

- get-stream:将流获取为字符串、缓冲区或数组

- into-stream:将缓冲区/字符串/数组/对象转换为流

结论:流的力量

Node.js 中的流就像是你开发者工具箱中的秘密武器。它们让你能够高效地处理数据,轻松处理大型数据集,并构建可扩展的应用程序。通过掌握流,你不仅仅是在学习Node.js的一个特性——你是在采用一种强大的数据处理范式。

记住,能力越大,责任越大。明智地使用流,愿你的数据始终顺畅流动!

“我流,你流,我们都流……为了高效的数据处理!” - 匿名Node.js开发者

现在去流动所有的东西吧!🌊💻