简要概述:Rust 1.80 协作调度的新特性

- 改进的任务让出机制

- 更好地与 Tokio 等异步运行时集成

- 增强的任务执行公平性

- 新的 API 提供更细粒度的任务调度控制

协作调度的难题

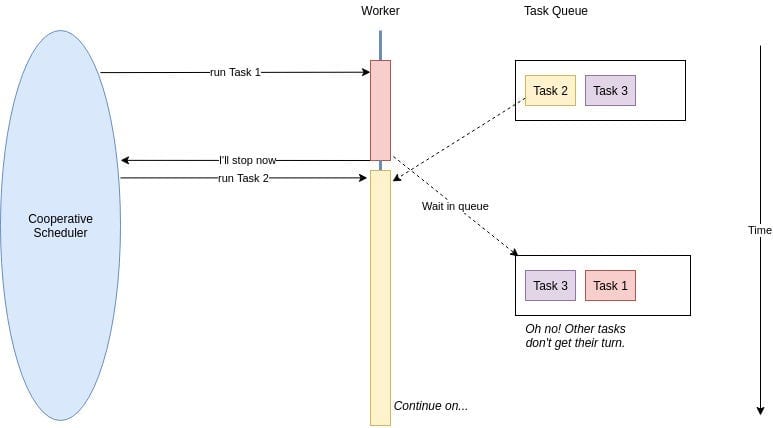

在深入探讨之前,让我们回顾一下协作调度的基本概念。在 Rust 的异步世界中,任务会友好地自愿让出控制权,让其他任务得以运行。这就像一群有礼貌的英国人排队,大家都愿意让别人先走。

然而,在 Rust 的早期版本中,这种礼貌有时会导致尴尬的情况。长时间运行的任务可能会占据资源,让其他关键操作等待。Rust 1.80 的到来,带来了新的方法,让这种“舞蹈”更加优雅。

新特性:增强的让出机制

Rust 1.80 引入了更复杂的让出机制,使任务成为更体贴的邻居。以下是如何使用这些新功能的快速示例:

use std::future::Future;

use std::pin::Pin;

use std::task::{Context, Poll};

struct YieldingTask {

yielded: bool,

}

impl Future for YieldingTask {

type Output = ();

fn poll(mut self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll {

if !self.yielded {

self.yielded = true;

cx.waker().wake_by_ref();

Poll::Pending

} else {

Poll::Ready(())

}

}

}

这个例子展示了一个任务在完成前让出一次。新的 wake_by_ref() 方法更高效,避免了不必要的 Waker 克隆。

Tokio 和 Rust 1.80:异步世界的完美结合

如果你在使用 Tokio(说实话,谁不是呢?),那么你会很高兴。Rust 1.80 的改进与 Tokio 的运行时完美结合。以下是如何利用这种协同效应:

use tokio::time::{sleep, Duration};

#[tokio::main]

async fn main() {

let task1 = tokio::spawn(async {

for i in 1..=5 {

println!("Task 1: {}", i);

sleep(Duration::from_millis(100)).await;

}

});

let task2 = tokio::spawn(async {

for i in 1..=5 {

println!("Task 2: {}", i);

sleep(Duration::from_millis(100)).await;

}

});

let _ = tokio::join!(task1, task2);

}

这个例子展示了 Tokio 的运行时如何与 Rust 1.80 的协作调度更好地配合,确保任务之间的公平执行。

公平性:不仅仅是操场上的争执

Rust 1.80 的一个突出特性是改进了任务执行的公平性。再也没有任务霸占所有 CPU 时间!运行时现在更好地分配任务资源,这对于高负载下的微服务至关重要。

考虑以下场景:

use tokio::time::{sleep, Duration};

use std::sync::Arc;

use std::sync::atomic::{AtomicUsize, Ordering};

#[tokio::main]

async fn main() {

let counter = Arc::new(AtomicUsize::new(0));

let tasks: Vec<_> = (0..100).map(|i| {

let counter = Arc::clone(&counter);

tokio::spawn(async move {

loop {

counter.fetch_add(1, Ordering::SeqCst);

if i % 10 == 0 {

sleep(Duration::from_millis(1)).await;

}

}

})

}).collect();

sleep(Duration::from_secs(5)).await;

for task in tasks {

task.abort();

}

println!("Total increments: {}", counter.load(Ordering::SeqCst));

}

在这个例子中,我们创建了 100 个任务,每个任务递增一个共享计数器。一些任务(每第 10 个)会短暂休眠,模拟 I/O 操作。借助 Rust 1.80 的改进公平性,你会注意到即使在这种人工负载下,任务之间的增量分布也更加均衡。

细粒度控制:你的新超能力

Rust 1.80 为任务调度提供了更多控制的新 API。就像为你的异步代码提供了一根魔法棒。以下是你可以做的一些事情:

use std::future::Future;

use std::pin::Pin;

use std::task::{Context, Poll};

struct ControlledYield {

yields_left: usize,

}

impl Future for ControlledYield {

type Output = ();

fn poll(mut self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll {

if self.yields_left > 0 {

self.yields_left -= 1;

cx.waker().wake_by_ref();

Poll::Pending

} else {

Poll::Ready(())

}

}

}

async fn controlled_task(yields: usize) {

ControlledYield { yields_left: yields }.await;

println!("Task completed after {} yields", yields);

}

这个 ControlledYield future 允许你指定任务在完成前应让出的次数。就像为每个任务的协作行为提供了一个精确的控制旋钮。

注意陷阱!

虽然 Rust 1.80 的协作调度改进非常出色,但它们并不是万能的。以下是一些需要注意的陷阱:

- 过度让出可能导致不必要的上下文切换和性能下降。

- 在 CPU 密集型任务中让出不足仍可能导致延迟峰值。

- 过于依赖运行时的公平性可能掩盖微服务架构中的潜在设计问题。

综合应用:一个真实场景

让我们看看如何在高负载下的微服务中应用这些改进:

use tokio::time::{sleep, Duration};

use std::sync::Arc;

use tokio::sync::Semaphore;

async fn process_request(id: u32, semaphore: Arc) {

let _permit = semaphore.acquire().await.unwrap();

println!("Processing request {}", id);

// Simulate some work

sleep(Duration::from_millis(100)).await;

println!("Completed request {}", id);

}

#[tokio::main]

async fn main() {

let semaphore = Arc::new(Semaphore::new(10)); // Limit concurrent processing

let mut handles = vec![];

for i in 0..1000 {

let sem = Arc::clone(&semaphore);

handles.push(tokio::spawn(async move {

process_request(i, sem).await;

}));

}

for handle in handles {

handle.await.unwrap();

}

}

在这个例子中,我们模拟了一个微服务同时处理 1000 个请求,但通过信号量将实际并发处理限制为 10 个。Rust 1.80 改进的协作调度确保即使在高负载下,每个任务都有公平的执行机会,防止任何单个请求垄断资源。

总结:拥抱协作精神

Rust 1.80 对协作调度的增强对于高负载下运行的微服务来说是一个游戏规则的改变。通过利用这些改进,你可以:

- 通过确保任务执行的公平性来减少延迟峰值

- 提高整体系统响应能力

- 优化异步代码以获得最佳性能

- 构建更具弹性的微服务,能够优雅地应对流量激增

记住,掌握这些新特性的关键在于实践和实验。不要害怕深入研究,看看它们如何改变你的微服务架构。

思考的食粮

“在微服务的世界中,合作不仅仅是锦上添花——它是生存的关键。”

在实施这些新的协作调度模式时,问问自己:

- 如何识别当前微服务中的瓶颈,这些瓶颈可以从改进的调度中受益?

- 我应该监控哪些指标以确保充分利用这些新特性?

- 我如何教育我的团队关于这些改进,并鼓励在异步 Rust 开发中采用最佳实践?

通过不断提出这些问题并探索 Rust 1.80 的功能,你将能够构建不仅能在压力下生存的微服务,还能蓬勃发展的微服务。

现在,去前所未有地合作吧!你的微服务(和你的用户)会感谢你。