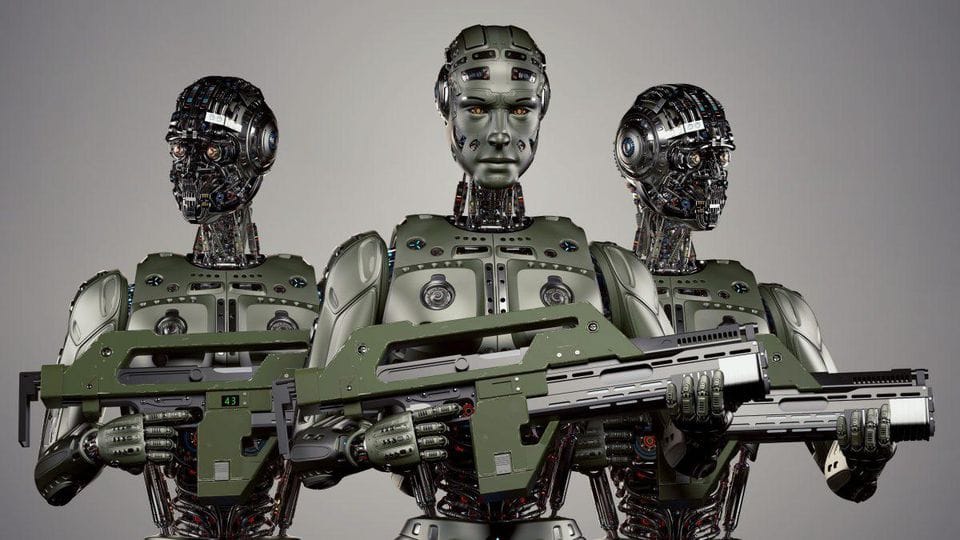

自主武器系统是能够在没有人类干预的情况下选择和攻击目标的军事平台。可以把它们想象成自动驾驶汽车的致命表亲。不同的是,它们不是在交通中导航,而是在战场上导航。而且它们不是为了避免碰撞,而是……你明白我的意思。

这些系统可以包括:

- 能够识别和攻击敌方阵地的自主无人机

- 能够在飞行中调整轨迹的AI导弹系统

- 守卫边界或敏感设施的机器人哨兵

这里的关键特征是自主性。与遥控武器不同,自主武器系统根据预先编程的参数和实时数据分析自行做出决策。

伦理雷区

现在我们已经了解了基本知识,让我们进入伦理的泥潭。自主武器系统的开发和部署引发了一系列道德问题,即使是最有经验的哲学家也会感到困惑。

1. 责任空白

当自主武器犯错时,谁该负责?是编写算法的程序员?还是部署它的军事指挥官?还是AI本身?这种“责任空白”是伦理辩论中的一个主要障碍。

“能力越大,责任越大” - 蜘蛛侠的叔叔本

但当这种能力由不理解责任概念的AI掌握时,会发生什么?

2. 武装冲突门槛降低

如果战争可以用机器人而不是人类士兵来进行,这是否使军事行动更容易被接受?有人担心,自主武器系统可能会降低武装冲突的门槛,使战争更频繁地发生。

3. 缺乏人类判断

人类可以考虑背景、细微差别和可能影响使用致命武力决策的最后时刻变化。我们真的可以信任AI来做出这些生死攸关的决定吗?

4. 滥用的潜力

在错误的人手中,自主武器系统可能被用于压迫、恐怖主义或其他邪恶目的。先进军事技术的普及是一把双刃剑。

当前的监管环境

那么,AI在战争中可以被监管吗?简短的回答是:我们在努力,但这很复杂。

目前,还没有专门针对自主武器系统的国际条约。然而,几个倡议正在进行中:

- 《特定常规武器公约》(CCW) 自2014年以来一直在讨论自主武器系统

- “停止杀手机器人运动”正在推动对完全自主武器的预防性禁令

- 一些国家,如比利时和卢森堡,已经在其军事学说中禁止了自主武器系统

挑战在于制定既具体又有效的法规,同时又足够灵活以适应快速的技术进步。

潜在的监管方法

让我们探讨一些可能的AI战争监管方法:

1. 国际条约

全面的国际条约可以为自主武器系统的发展和使用设定明确的指导方针。这可能包括:

- 定义什么是自主武器

- 自主武器系统的交战规则

- 当事情出错时的问责机制

2. “人类在环”要求

在所有自主武器系统操作中强制要求人类监督可以帮助解决一些伦理问题。这可以在不同层面实施:

def autonomous_weapon_system(target):

if human_approval():

engage_target(target)

else:

stand_down()

def human_approval():

# 这个函数需要人类操作员批准行动

return input("批准目标攻击?(y/n): ") == 'y'

3. 伦理AI设计

将伦理考虑纳入AI系统的设计中可以帮助减轻一些风险。这可能涉及:

- 编程战争法和交战规则

- 实施强大的故障保护和中止机制

- 设计具有透明性和可审计性的系统

4. 国际监测机构

可以建立一个独立的国际机构来监测自主武器系统的发展和部署,类似于国际原子能机构在核不扩散中的角色。

前方的道路

监管战争中的AI是一项艰巨的任务,但我们不能忽视它。随着技术以惊人的速度继续发展,我们的伦理和监管框架需要跟上步伐。

以下是未来的一些关键考虑因素:

- 跨学科合作:我们需要伦理学家、技术专家、政策制定者和军事专家共同努力制定有效的法规。

- 透明度:开发自主武器系统的国家应对其能力和意图保持透明。

- 持续对话:随着技术的发展,我们对其监管的方法也应随之演变。定期的国际讨论至关重要。

- 公众意识:自主武器系统的影响不应仅仅是专家的关注。公众的理解和参与至关重要。

思考的食粮

在我们结束对自主武器伦理的深入探讨时,这里有一些问题供大家思考:

- 是否有可能创建一个在战争中能比人类更好地做出伦理决策的AI系统?

- 我们如何平衡自主武器系统的潜在好处(如减少人类伤亡)与伦理风险?

- 自主武器系统的发展是否可能导致AI军备竞赛?如果是,我们如何防止它?

关于自主武器系统的辩论远未结束。作为技术人员,我们必须参与这些伦理问题的讨论。毕竟,我们今天编写的代码可能会塑造明天的战场。

“真正的问题不是机器是否思考,而是人类是否思考。” - B.F. 斯金纳

让我们确保我们在深思熟虑地考虑我们工作的影响。战争的未来——甚至可能是人类本身——可能取决于此。