挑战:同步而不陷入困境

在不同地区的多个S3存储桶之间同步对象就像在管理一群数据猫——如果这些猫在你不注意的时候会成倍增加。我们面临的主要障碍是:

- 来自不同地区的并发更新

- 网络分区导致的临时隔离

- 存储桶之间的版本差异

- 需要最终一致性而不牺牲可用性

传统的锁定机制或中央协调器?在这里,它们的用处就像撒哈拉沙漠中的巧克力茶壶。我们需要一些更具事件性的东西。

CRDTs:分布式系统的和平使者

无冲突复制数据类型(CRDTs)是分布式系统中不为人知的英雄。它们是可以在网络中的多台计算机上复制的数据结构,副本可以独立并发更新,无需协调,并且总是可以数学上解决可能产生的不一致。

对于我们的S3复制器,我们将使用一种特定类型的CRDT,称为仅增计数器(G-Counter)。它非常适合处理版本差异,因为它只允许增加,不允许减少。就像数据版本号的单行道。

实现G-Counter

以下是一个简单的Python中G-Counter实现:

class GCounter:

def __init__(self):

self.counters = {}

def increment(self, node_id):

if node_id not in self.counters:

self.counters[node_id] = 0

self.counters[node_id] += 1

def merge(self, other):

for node_id, count in other.counters.items():

if node_id not in self.counters or self.counters[node_id] < count:

self.counters[node_id] = count

def value(self):

return sum(self.counters.values())

这个G-Counter允许每个节点(在我们的例子中,每个S3存储桶)独立增加自己的计数器。当需要同步时,我们只需合并计数器,取每个节点的最大值。

Lambda@Edge:你的分布式看门狗

现在我们有了CRDT,我们需要一种方法来传播S3存储桶之间的变化。引入Lambda@Edge,这是AWS的解决方案,可以在AWS边缘位置全球运行你的Lambda函数。就像在世界每个角落都有一个小而高效的机器人,随时准备行动。

我们将使用Lambda@Edge来:

- 检测我们任何一个S3存储桶中的变化

- 更新本地G-Counter

- 将变化传播到其他存储桶

- 合并来自不同存储桶的G-Counter

设置Lambda@Edge

首先,让我们创建一个Lambda函数,该函数将在S3对象创建或更新时触发:

import boto3

import json

from gcounter import GCounter

def lambda_handler(event, context):

# 从事件中提取存储桶和对象信息

bucket = event['Records'][0]['s3']['bucket']['name']

key = event['Records'][0]['s3']['object']['key']

# 初始化S3客户端

s3 = boto3.client('s3')

# 从对象元数据中读取当前G-Counter

try:

response = s3.head_object(Bucket=bucket, Key=key)

current_counter = json.loads(response['Metadata'].get('g-counter', '{}'))

except:

current_counter = {}

# 创建一个新的G-Counter并与当前的合并

g_counter = GCounter()

g_counter.counters = current_counter

g_counter.increment(bucket)

# 使用新的G-Counter更新对象元数据

s3.copy_object(

Bucket=bucket,

CopySource={'Bucket': bucket, 'Key': key},

Key=key,

MetadataDirective='REPLACE',

Metadata={'g-counter': json.dumps(g_counter.counters)}

)

# 将变化传播到其他存储桶

propagate_changes(bucket, key, g_counter)

def propagate_changes(source_bucket, key, g_counter):

# 要同步的所有存储桶列表

buckets = ['bucket1', 'bucket2', 'bucket3'] # 在此添加你的存储桶名称

s3 = boto3.client('s3')

for target_bucket in buckets:

if target_bucket != source_bucket:

try:

# 从源存储桶获取对象

response = s3.get_object(Bucket=source_bucket, Key=key)

# 将对象复制到目标存储桶

s3.put_object(

Bucket=target_bucket,

Key=key,

Body=response['Body'].read(),

Metadata={'g-counter': json.dumps(g_counter.counters)}

)

except Exception as e:

print(f"Error propagating changes to {target_bucket}: {str(e)}")

这个Lambda函数负责更新G-Counter并将变化传播到其他存储桶。就像一个过度活跃的章鱼,同时伸向所有存储桶。

处理版本差异

现在,让我们解决房间里的大象:版本差异。我们的G-Counter在这里派上用场。由于它只允许增加,我们可以用它来确定哪个版本的对象在所有存储桶中是最新的。

以下是我们如何修改Lambda函数以处理版本:

def resolve_version_conflict(bucket, key, g_counter):

s3 = boto3.client('s3')

# 获取对象的所有版本

versions = s3.list_object_versions(Bucket=bucket, Prefix=key)['Versions']

# 找到具有最高G-Counter值的版本

latest_version = max(versions, key=lambda v: GCounter().merge(json.loads(v['Metadata'].get('g-counter', '{}'))))

# 如果最新版本不是当前版本,则更新它

if latest_version['VersionId'] != versions[0]['VersionId']:

s3.copy_object(

Bucket=bucket,

CopySource={'Bucket': bucket, 'Key': key, 'VersionId': latest_version['VersionId']},

Key=key,

MetadataDirective='REPLACE',

Metadata={'g-counter': json.dumps(g_counter.counters)}

)

这个函数检查对象的所有版本,并确保具有最高G-Counter值的版本被设置为当前版本。就像一个时间旅行的历史学家,总是确保呈现最新的历史版本。

大局:整合一切

那么,我们在这里构建了什么?让我们分解一下:

- 一个G-Counter CRDT来处理版本和冲突解决

- 一个Lambda@Edge函数,它:

- 检测S3存储桶中的变化

- 更新G-Counter

- 将变化传播到其他存储桶

- 解决版本冲突

这个系统允许我们在多个S3存储桶之间保持最终一致性,而不牺牲可用性。就像拥有一个自组织、自愈的数据生态系统。

潜在的陷阱和考虑

在你将其应用于生产之前,请记住以下几点:

- Lambda@Edge有一些限制,包括执行时间和负载大小。对于大对象,你可能需要实现分块策略。

- 该解决方案假设网络分区是暂时的。在长时间分区的情况下,你可能需要额外的对账机制。

- G-Counter会随着时间增长。对于频繁更新的长寿命对象,你可能需要实现修剪策略。

- 在部署到生产环境之前,始终在测试环境中彻底测试。分布式系统可能是棘手的野兽!

总结:为什么要费心?

你可能会想,“为什么要费这么大劲?我不能只用AWS的内置复制吗?”嗯,是的,你可以。但我们的解决方案提供了一些独特的优势:

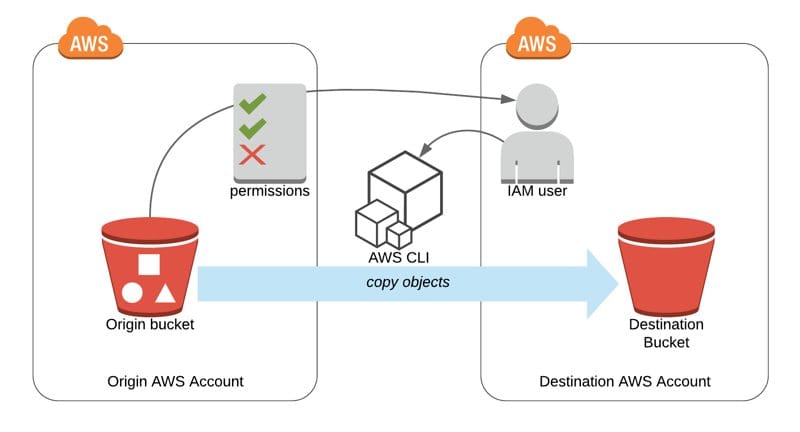

- 它适用于不同的AWS账户和地区,而不仅限于单个账户内。

- 在网络分区和并发更新的情况下,它提供了更强的一致性保证。

- 它更灵活,可以根据特定的业务逻辑或数据模型进行定制。

最终,这种方法让你对数据同步过程有更精细的控制。就像是分布式数据乐团的指挥,确保每个乐器(在这种情况下,每个S3存储桶)都能完美和谐地演奏。

思考的食粮

在你实现这个解决方案时,考虑以下问题:

- 你会如何修改这个系统来处理删除?

- 这种方法可以扩展到S3以外的其他AWS服务吗?

- 在分布式云架构中,哪些其他类型的CRDT可能有用?

记住,在分布式系统的世界里,没有一种万能的解决方案。但有了CRDTs和Lambda@Edge在你的工具箱中,你就有能力解决最具挑战性的数据同步问题。现在去吧,愿你的数据始终保持同步!